作者:趙健??

年前的 1 月 27 日,「甲子光年」參加了一場 AI 生成視頻主題的沙龍,會上有一個有趣的互動:AI 視頻生成多快迎來 “Midjourney 時刻”?

選項分別是半年內、一年內、1-2 年或更長。

昨天,OpenAI 公布了準確答案:20 天。

OpenAI 昨天發布了全新的 AI 生成視頻模型 Sora,憑借肉眼可見的性能優勢與長達 60s 的視頻生成時長,繼文本(GPT-4)和圖像(DALL·E 3)之后,也在視頻生成領域取得了“遙遙領先”。我們距離 AGI(通用人工智能)又近了一步。

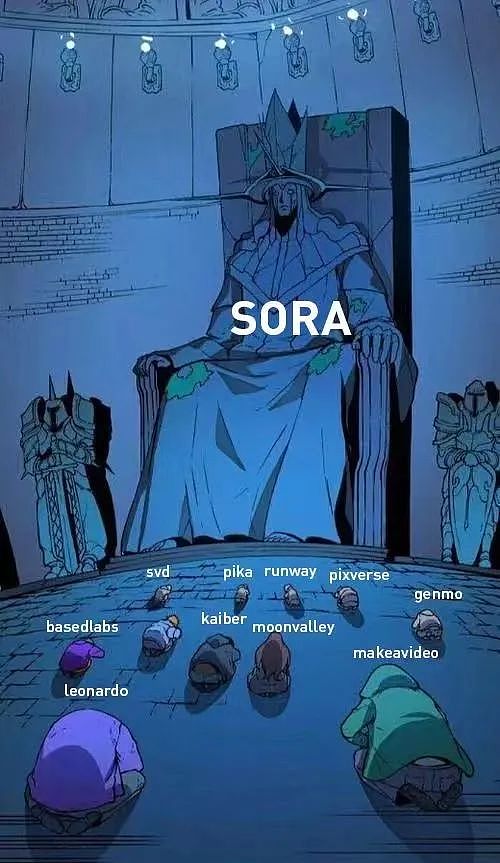

值得一提的是,明星 AI 公司 Stability AI 昨天原本發布了一個新的視頻模型 SVD1.1,但由于與 Sora 撞車,其官方推文已被火速刪除。

AI 視頻生成的領頭羊之一 Runway 的聯合創始人、CEO Cristóbal Valenzuela 發推文表示:“比賽開始了(game on)。”

OpenAI 昨天還發布了一份技術文檔,但無論從模型架構還是訓練方法,都未發布什么天才級的創新技術,更多是現有技術路線的優化。

但跟一年多以前橫空出世的 ChatGPT 一樣,OpenAI 的秘訣都是屢試不爽的 Scaling Law(縮放定律)——當視頻模型足夠“大”,就會產生智能涌現的能力。

問題在于,大模型訓練的“暴力美學”幾乎已經人盡皆知,為什么這次又是 OpenAI ?

生成視頻的技術路線主要經歷了四個階段:循環網絡(recurrent networks,RNN)、生成對抗網絡(generative adversarial networks,GAN)、自回歸模型(autoregressive transformers)、擴散模型(diffusion models)。

今天,領先的視頻模型大多數是擴散模型,比如 Runway、Pika 等。自回歸模型由于更好的多模態能力與擴展性也成為熱門的研究方向,比如谷歌在 2023 年 12 月發布的 VideoPoet。

Sora 則是一種新的 diffusion transformer 模型。從名字就可以看出,它融合了擴散模型與自回歸模型的雙重特性。Diffusion transformer 架構由加利福尼亞大學伯克利分校的 William Peebles 與紐約大學的 Saining Xie 在 2023 年提出。

如何訓練這種新的模型?在技術文檔中,OpenAI 提出了一種用 patch(視覺補丁)作為視頻數據來訓練視頻模型的方式,這是從大語言模型的 token 汲取的靈感。Token 優雅地統一了文本的多種模式——代碼、數學和各種自然語言,而 patch 則統一了圖像與視頻。

OpenAI 訓練了一個網絡來降低視覺數據的維度。這個網絡接收原始視頻作為輸入,并輸出一個在時間和空間上都被壓縮的潛在表示(latent representation)。Sora 在這個壓縮的潛在空間上進行訓練,并隨后生成視頻。OpenAI 還訓練了一個相應的解碼器模型,將生成的潛在表示映射回像素空間。

OpenAI 表示,過去的圖像和視頻生成方法通常會將視頻調整大小、裁剪或修剪為標準尺寸,而這損耗了視頻生成的質量,例如分辨率為 256x256 的 4 秒視頻。而將圖片與視頻數據 patch 化之后,無需對數據進行壓縮,就能夠對不同分辨率、持續時間和長寬比的視頻和圖像的原始數據進行訓練。

這種數據處理方式為模型訓練帶來了兩個優勢:

第一,采樣靈活性。Sora 可以采樣寬屏 1920x1080p 視頻、垂直 1080x1920 視頻以及介于兩者之間的所有視頻,直接以其原生寬高比為不同設備創建內容,并且能夠在以全分辨率生成視頻之前,快速地以較低尺寸制作原型內容。這些都使用相同的模型。

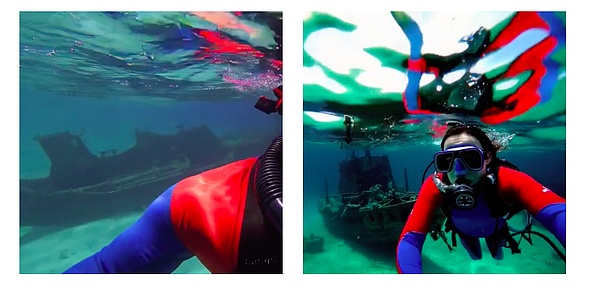

第二,改進框架與構圖。OpenAI 根據經驗發現,以原始長寬比對視頻進行訓練可以改善構圖和取景。比如,常見的將所有訓練視頻裁剪為正方形的模型,有時會生成僅部分可見主體的視頻。相比之下,Sora 的視頻取景有所改善。

在方形作物上訓練的模型(左),Sora 的模型(右)

在語言理解層面,OpenAI 發現,對高度描述性視頻字幕進行訓練可以提高文本保真度以及視頻的整體質量。

為此,OpenAI 應用了 DALL·E 3 中引入的“重新字幕技術”(re-captioning technique)——首先訓練一個高度描述性的字幕生成器模型,然后使用它為訓練數據集中的視頻生成文本字幕。

此外,與 DALL·E 3 類似,OpenAI 還利用 GPT 將簡短的用戶提示轉換為較長的詳細字幕,然后發送到視頻模型。這使得 Sora 能夠生成準確遵循用戶提示的高質量視頻。

提示詞:a woman wearing blue jeans and a white t-shirt,taking a pleasant stroll in Mumbai India during a colorful festival.

除了文本生成視頻之外,Sora 也支持“圖像生成視頻”與“視頻生成視頻”。

提示詞:In an ornate, historical hall, a massive tidal wave peaks and begins to crash. Two surfers, seizing the moment, skillfully navigate the face of the wave.

此功能使 Sora 能夠執行各種圖像和視頻編輯任務,創建完美的循環視頻、動畫靜態圖像、及時向前或向后擴展視頻等。

在 Sora 的技術文檔里,OpenAI 并沒有透露模型的技術細節(埃隆·馬斯克曾經抨擊 OpenAI 不再像它成立時的初衷一樣“open”),而只是表達了一個核心理念——scale。

OpenAI 在 2020 年首次提出了模型訓練的秘訣——Scaling Law。根據 Scaling Law,模型性能會在大算力、大參數、大數據的基礎上像摩爾定律一樣持續提升,不僅適用于語言模型,也適用于多模態模型。

OpenAI 就是遵循這一套“暴力美學”發現了大語言模型的涌現能力,并最終研發出劃時代的 ChatGPT 。

Sora 模型也是如此,憑借Scaling Law,它毫無預兆地在 2024 年 2 月就打響了視頻的 “Midjourney 時刻”。

OpenAI 表示,transformer 在各個領域都表現出了卓越的擴展特性,包括語言建模、計算機視覺、圖像生成以及視頻生成。下圖展示了訓練過程中,在相同的樣本下,隨著訓練計算規模的增加,視頻質量顯著提高。

OpenAI 發現,視頻模型在大規模訓練時表現出許多有趣的新興功能,使 Sora 能夠模擬現實世界中人、動物和環境的某些方面。這些屬性的出現對 3D、物體等沒有任何明確的歸納偏差——純粹是模型縮放現象。

因此,OpenAI 將視頻生成模型,命名為“世界模擬器”(world simulators),或稱之為“世界模型”——可以理解為讓機器像人類理解世界的方式一樣學習。

英偉達科學家 Jim Fan 如此評價道:“如果您認為 OpenAI Sora 是像 DALL·E 一樣的創意玩具......再想一想。 Sora 是一個數據驅動的物理引擎。它是對許多世界的模擬,無論是真實的還是幻想的。模擬器通過一些去噪和梯度數學來學習復雜的渲染、‘直觀’物理、長期推理和語義基礎。”

Meta 首席科學家楊立昆(Yann LeCun)曾在 2023 年 6 月提出世界模型的概念。2023 年 12 月,Runway 官宣下場通用世界模型,宣稱要用生成式 AI 來模擬整個世界。

而 OpenAI 僅僅通過早就熟稔于心的 Scaling Law,讓 Sora 具備了世界模型的能力。OpenAI 表示:“我們的結果表明,擴展視頻生成模型是構建物理世界通用模擬器的一條有前途的途徑。”

具體來看,Sora 世界模型有三個特點:

3D 一致性。Sora 可以生成帶有動態攝像機運動的視頻。隨著攝像機的移動和旋轉,人和場景元素在三維空間中一致移動。

遠程相關性和物體持久性。視頻生成系統面臨的一個重大挑戰是在采樣長視頻時保持時間一致性。OpenAI 發現 Sora 通常(盡管并非總是)能夠有效地對短期和長期依賴關系進行建模。例如,模型可以保留人、動物和物體,即使它們被遮擋或離開框架。同樣,它可以在單個樣本中生成同一角色的多個鏡頭,并在整個視頻中保持其外觀。

與世界互動。Sora 有時可以用簡單的方式模擬影響世界狀況的動作。例如,畫家可以在畫布上留下新的筆觸,并隨著時間的推移而持續存在。

模擬數字世界。?Sora 還能夠模擬人工過程——一個例子是視頻游戲。 Sora 可以同時通過基本策略控制《我的世界》中的玩家,同時以高保真度渲染世界及其動態。這些能力可以通過用提及“我的世界”的標題提示 Sora 來實現零射擊。

不過,跟所有的大模型一樣,Sora 還不是一個完美的模型。OpenAI 承認,Sora 還存在許多局限性,它不能準確地模擬許多基本相互作用的物理過程,例如玻璃破碎。其他交互(例如吃食物)并不總是會產生對象狀態的正確變化。

我們或許能找到很多原因,比如對 AGI 的信仰、對技術的堅持等。但一個現實因素是,Scaling Law 需要高昂的算力支出來支撐,而這正是 OpenAI 比較擅長的。

如此一來,視頻模型的競爭點就有點類似于語言模型,先是拼團隊的工程化調參能力,拼到最后就是拼算力。

歸根到底,這顯然又是英偉達的機會。在這一輪 AI 熱潮的驅動下, 英偉達的市值已經節節攀升,一舉超越了亞馬遜與谷歌。

視頻模型的訓練會比語言模型更加耗費算力。在算力全球緊缺的狀況下,OpenAI 如何解決算力問題?如果結合此前關于 OpenAI 的造芯傳聞,似乎一切就順理成章了。

去年起,OpenAI CEO 薩姆·奧爾特曼(Sam Altman)就在與為代號「Tigris」的芯片制造項目籌集 80 億至 100 億美元的資金,希望生產出類似谷歌TPU,能與英偉達競爭的 AI 芯片,來幫助 OpenAI 降低運行和服務成本。

2024 年 1 月,奧爾特曼還曾到訪韓國,會見韓國三星電子和 SK 海力士高管尋求芯片領域的合作。

近期,根據外媒報道,奧爾特曼正在推動一個旨在提高全球芯片制造能力的項目,并在與包括阿聯酋政府在內的不同投資者進行談判。這一計劃籌集的資金,達到了夸張的 5 萬億~ 7 萬億美元。

OpenAI 發言人表示:“OpenAI 就增加芯片、能源和數據中心的全球基礎設施和供應鏈進行了富有成效的討論,這對于人工智能和相關行業至關重要。鑒于國家優先事項的重要性,我們將繼續向美國政府通報情況,并期待稍后分享更多細節。”

英偉達創始人兼 CEO 黃仁勛對此略顯諷刺地回應道:“如果你認為計算機無法發展得更快,可能會得出這樣的結論:我們需要 14 顆行星、 3 個星系和 4 個太陽來為這一切提供燃料。但是,計算機架構其實在不斷地進步。”

到底是大模型的發展速度更快,還是算力成本的降低速度更快?它會成為百模大戰的勝負手嗎?

2024 年,答案會逐漸揭曉。